Le 23 octobre dernier, Google rendait publique une étude qui se targuait d'avoir atteint, pour la première fois, la suprématie quantique. Elle était aussitôt propagée dans l'espace médiatique international, stupéfait par le caractère fracassant de la nouvelle. Si l'on veut s'y retrouver, quelques explications s'imposent.

L’ordinateur classique et la loi de Moore

Un ordinateur classique est alimenté par l'énergie électrique. Son architecture est basée sur des processeurs dont les unités d'information, les bits, ne peuvent se trouver que dans deux états : soit le courant passe (tension dépassant le seuil minimal), soit il ne passe pas (tension trop faible ou nulle). Pour procéder au traitement des données et effectuer les nombreux calculs, il a donc semblé naturel d'adopter un système de numération en base 2, le système binaire. Contrairement au système décimal avec ses dix symboles si familiers (0 à 9), un tel système ne comporte en effet que deux valeurs, 0 et 1. Appliqué à l'ordinateur, cela donne 0 quand le courant ne passe pas, 1 dans le cas contraire1. Ainsi, le chiffre 4 s’écrira 100 en mode binaire, 14 donnera 1110, 66 se traduira par 1000010, etc.

C'est ainsi que sont codées toutes les données de nos appareils électroniques actuels, qu'on parle de nombres, de mots ou d'images. À première vue, une telle façon de coder exige beaucoup de temps, mais, comme la lumière, l'électricité est une impulsion électromagnétique voyageant en principe à la vitesse la plus élevée de l'univers, ce qui change le portrait du tout au tout. Cela dit, bien des facteurs peuvent affecter cette vitesse théorique et faire varier énormément la capacité de traitement d'un ordinateur. La fréquence du processeur constitue un premier facteur déterminant cette capacité : plus la cadence est élevée, plus l'ordinateur sera rapide. Pour augmenter la vitesse, on peut aussi installer des processeurs utilisant le traitement en parallèle. Par ailleurs, d'autres facteurs moins importants influent également sur la capacité de l'appareil, tels la vitesse du signal électromagnétique2, la quantité de mémoire RAM, le codage des logiciels utilisés (32 bits ou 64 bits) ou la vitesse du bus de la carte mère3.

Avec les années, on a évidemment cherché à améliorer la puissance et l'efficacité des ordinateurs pour répondre aux besoins grandissants de la recherche, mais aussi aux exigences des entreprises développant des produits pour les utilisateurs. D'où la célèbre loi de Moore. Gordon Moore est ce physicien et chimiste américain né en 1929, qui a cofondé en 1968 la compagnie Intel, aujourd'hui encore le premier fabricant mondial de semi-conducteurs et de microprocesseurs. Sa loi affirme que la puissance des ordinateurs double environ tous les dix-huit mois4. Comme ce doublement périodique constitue une progression géométrique, laquelle se poursuit maintenant depuis plus de cinquante ans, la course à la miniaturisation approche de sa limite5, comme aussi l'architecture actuelle des ordinateurs ; c'est ce que les ingénieurs appellent le Mur (« the Wall »).

C'est ici qu'entre en jeu l'ordinateur quantique.

Ordinateur quantique et qubits

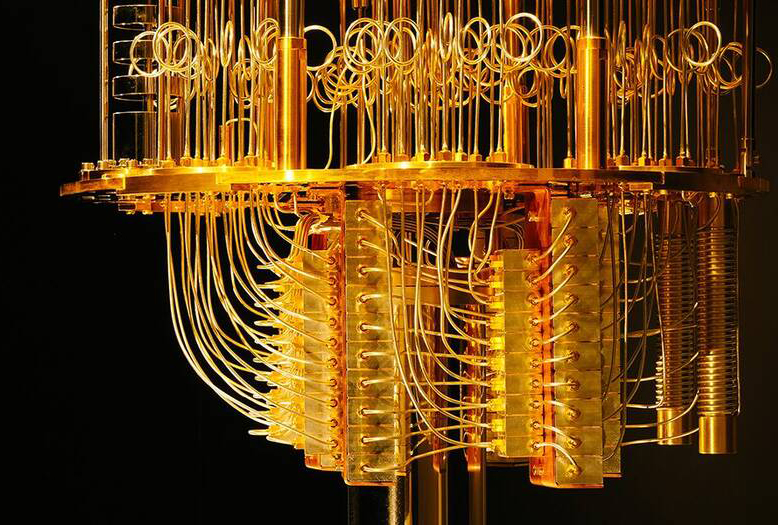

Comme son nom l'indique, cet ordinateur utilise les propriétés du monde quantique6, un domaine qui n'obéit pas aux lois usuelles de la logique. Dans l'univers étrange de l’infiniment petit règne en effet la dualité ondes-particules. De plus, certains systèmes, par exemple les particules subatomiques, peuvent se trouver dans plusieurs états à la fois7. En s'appuyant sur cette propriété de superposition, on a créé les qubits, les bits quantiques. Comme le bit de l'électronique conventionnelle, le qubit est l'unité qui emmagasine l'information. Cependant, contrairement à sa contrepartie, il ne se trouve pas forcément dans l'état correspondant au 0 ou au 1 ; il peut parfaitement présenter une superposition des deux états. C'est ce qui en fait l'intérêt, car on peut, en principe, traiter une quantité illimitée d'informations avec un nombre réduit de qubits. En effet, deux qubits peuvent prendre quatre valeurs, trois qubits, huit, ainsi de suite. Alors que la puissance de l'ordinateur classique double seulement quand on parvient à augmenter la cadence du processeur ou à multiplier les puces en conséquence, celle de l'ordinateur quantique double avec l’ajout de chaque qubit, le nombre d'états augmentant selon une progression géométrique, soit 2N états pour N qubits. Autrement dit, la propriété de superposition s'appliquant à chaque unité d'information, la puissance du processeur devient une fonction exponentielle de leur nombre. On peut en conséquence obtenir un appareil d'une capacité phénoménale avec un très petit nombre de qubits. La plupart des modèles expérimentaux fonctionnent avec moins de 60. Mais cela suffit amplement, car la progression géométrique aidant, un ordinateur de 53 qubits, comme celui de Google, possédera 253 états possibles, soit 9 quadrillions et des poussières8. Quand on songe au fait que, pour une puissance théoriquement moindre, les ordinateurs classiques doivent maintenant loger des milliards de transistors sur leurs puces9, le gain est absolument phénoménal.

Cette capacité de traitement sans égale permet d'obtenir, en un temps record, le résultat de calculs qui exigeraient un interminable travail de la part d'un supercalculateur classique, fût-il l'un des plus puissants de la planète et utilisât-il les meilleurs algorithmes actuellement disponibles. Sans nul doute, on construira éventuellement des ordinateurs comprenant davantage de qubits. Or, la progression géométrique débouche rapidement sur des chiffres vertigineux. Ainsi, un ordinateur de 63 qubits serait en principe 1024 fois plus puissant que celui de Google, un ordinateur de 73 qubits 1 048 000 de fois plus puissant, ainsi de suite. Mais d'ores et déjà, avec cet appareil qui représente encore l'enfance de l'informatique quantique, leur équipe de chercheurs serait parvenue à effectuer « en 200 secondes » un calcul qui demanderait, en temps normal, « environ 10 000 ans »...

La course au quantique

Ce résultat stupéfiant illustre parfaitement le sens de l'expression utilisée par l'entreprise de Santa Barbara : la suprématie quantique. Proposée par le physicien américain John Preskill en 2012, elle fait référence à des performances qu'aucun ordinateur conventionnel ne peut égaler. Cela dit, il faut rappeler qu'une impitoyable course contre la montre est actuellement engagée entre les grandes puissances mondiales, surtout les États-Unis, le Japon et la Chine10, comme entre les entreprises américaines elles-mêmes. Ainsi, au moment où Google publiait son étude, la compagnie IBM faisait elle aussi une annonce étonnante : elle conviait la communauté des chercheurs à louer du temps d'utilisation sur une machine quantique à première vue équivalente, puisque, comme sa rivale, elle mobilise 53 qubits. Ce parent a été dévoilé en janvier dernier, lors du Consumer Electronics Show de Las Vegas11. Baptisée Q System One, on peut le considérer comme le premier ordinateur quantique à vocation commerciale. Or, cet appareil se présente sous la forme d'un immense cube de verre trempé abritant un énorme pendentif cylindrique chromé, que l'on avait dénudé pour la circonstance, et il ne ressemble en rien à nos ordinateurs actuels. Chacune de ses faces fait près de trois mètres. Rares sont par conséquent les salles ou les bureaux qui pourraient accommoder ce monstre exotique aux caractéristiques hors du commun. Quant au prix d'une telle machine, il est actuellement prohibitif. C'est sans doute la raison pour laquelle, plutôt qu'une commercialisation au sens usuel, l'entreprise a décidé d'en louer le temps d'utilisation par le biais d’Internet et de l'infonuagique, comme on le fait parfois pour les supercalculateurs classiques.

...cet appareil se présente sous la forme d'un immense cube de verre trempé abritant un énorme pendentif cylindrique chromé, que l'on avait dénudé pour la circonstance, et il ne ressemble en rien à nos ordinateurs actuels.

À Google et IBM, il faut encore ajouter Microsoft et Intel, le premier misant sur un projet d'ordinateur quantique topologique12, et le second fondant beaucoup d'espoir sur une puce appelée Tangle Lake, le nom d'un lac en Alaska13. Pourquoi ce toponyme étonnant? C'est d'abord un clin d'œil à l'État le plus froid des États-Unis, on verra tout à l'heure pourquoi, ensuite une allusion au réseau, puisque Tangle Lakes constitue en fait un archipel de lacs interreliés, ce qui évoque plaisamment le phénomène de l'intrication quantique. L'intrication, rappelons-le, est la propriété qu'ont certains systèmes quantiques de maintenir des états corrélés, quelle que soit la distance qui les sépare. En l'absence de connexion physique, c'est une propriété indispensable : elle permet de tirer parti de l'état de superposition d'un ensemble de qubits, sinon ils ne peuvent interagir en parallèle et travailler de concert. Elle rend aussi les divers qubits cohérents, c'est-à-dire qu'elle leur permet d'adopter simultanément les deux états quantiques souhaités.

En somme, si l'on considère l'implacable course en cours et les milliards de dollars à la clé, peut-être faut-il faire la part de la publicité et de la surenchère dans l'étude de Google, qui pourrait avoir quelque peu embelli ses résultats14. Cependant, l'article officiel de ce géant du numérique ayant paru dans la prestigieuse revue Nature15, on dispose au moins d'un solide gage de crédibilité.

Des problèmes techniques redoutables

Cela dit, autant les promesses de l'ordinateur quantique sont fantastiques, autant les difficultés techniques qu'il pose sont redoutables. On a déjà évoqué la superposition et la nécessité de l'intrication. Avant d'aller plus loin, il vaut la peine de toucher un mot de certains autres défis.

Pour obtenir leurs étourdissants résultats, les chercheurs doivent d'abord choisir des atomes simples et les isoler du monde extérieur. Ensuite, il faut stabiliser l'état quantique des qubits. En effet, pour qu'ils fonctionnent correctement, on doit obtenir ce qu'on appelle le temps de cohérence, c'est-à-dire le temps pendant lequel l'interaction entre le qubit et son environnement est suffisamment faible pour que la superposition soit maintenue ; autrement, ils perdent leurs propriétés et ne sont plus opérationnels. Or, la conservation de la cohérence suppose des conditions exceptionnelles, dont le maintien du système à une température avoisinant le zéro absolu et l'isolement complet afin d'empêcher tout bruit et toute vibration, même les plus infimes. Et même dans ces conditions, le temps de cohérence se calcule parfois en millisecondes. Heureusement, comme l'architecture du processeur quantique autorise des performances qui défient l'imagination, ces fractions de seconde dérisoires suffisent pour effectuer une quantité astronomique d'opérations. Je viens d'évoquer des températures infiniment plus basses que celles qui règnent dans le vide intersidéral. Pourquoi? C'est qu'on utilise la supraconductivité. La supraconductivité, c'est, rappelons-le, la capacité d'éliminer presque toute résistance au transport de l'influx électromagnétique. Pour qu'elle soit optimale, on a avantage à utiliser certains matériaux spécifiques et il faut en outre les refroidir sous leurs seuils critiques, habituellement à des températures extrêmement basses. C'est la raison pour laquelle certaines parties du processeur quantique utilisent, non le traditionnel silicium, mais des métaux adaptés, tels le niobium, le gallium ou l'or.

On le voit, la maîtrise de ces technologies de pointe n'est pas à la portée de tous les laboratoires, car réussir à combiner ces diverses manipulations, aussi complexes les unes que les autres, constitue un véritable tour de force.

Un saut dans l'inconnu

L'équipe de Google a baptisé son processeur révolutionnaire Sycamore. Sortir ce prototype du laboratoire demandera encore beaucoup de travail et de temps. Il faudra d'abord réduire les coûts exorbitants de l'ordinateur quantique et sa taille éléphantesque. Surtout, il faudra trouver un moyen de maintenir des conditions d'une extrême délicatesse dans de petits appareils portatifs. Le défi est colossal. Aussi y a-t-il loin de la coupe aux lèvres. Comme l'a fait remarquer Sundar Pichai, président-directeur général de Google depuis la restructuration de l'entreprise et la création d'Alphabet en 2015, obtenir un résultat en laboratoire est une chose, en tirer des applications industrielles et commercialiser un hypercalculateur, c'est autre chose. Bref, les adolescents de la planète devront patienter : le quantique grand public ne frappe pas encore à nos portes et aucun cellulaire futuriste aux excitantes propriétés ne pointe encore à l'horizon...

Cela dit, comme le montrent les exemples d'IBM ou de Google, une étape importante est déjà franchie, et on y arrivera sans doute tôt ou tard. Tout le monde en convient, ce sera une avancée phénoménale pour l'univers informatique, un pas décisif vers le Graal de la recherche numérique. En fait, le bond qualitatif réalisé par Google relègue déjà la loi de Moore au rayon des antiquités, puisqu'on ne parle plus ici d'un doublement périodique des capacités en fonction de la multiplication des puces ou du perfectionnement constant des microprocesseurs, mais d'une modification fondamentale de l'architecture même de l'ordinateur, bref, d'un saut... quantique. Et comme les propriétés de ce monde déroutant échappent aux règles de la physique classique, de même ces ordinateurs d'un nouveau type laissent entrevoir des prouesses techniques inaccessibles aux ordinateurs actuels ; c'est l'idée même de suprématie quantique.

Jusqu'où pourra-t-on aller? Présentement, personne ne saurait le dire. Mais ces appareils inédits pourront mettre à profit des algorithmes sans équivalents actuels, et peut-être résoudre des problèmes ayant déjoué jusqu'ici la sagacité des meilleurs chercheurs. On songe entre autres à de nombreux domaines en effervescence, telles la cryptographie, l'intelligence artificielle ou la robotique. Mais peut-être peut-on imaginer plus ambitieux encore. Quand Feynman, l'un des trois fondateurs de l'électrodynamique quantique, donna sa célèbre conférence de 1959, « There's Plenty of Room at the Bottom: An Invitation to Enter a New Field of Physics », il indiquait une voie qui ne prit véritablement son essor que trente ans plus tard, avec le début des nanotechnologies. De même, dans une autre de ses remarquables conférences, « Simulating Physics with Computers »16, il a lancé l'idée folle d'un simulateur quantique universel. « La nature n'est pas classique, disait-il. [...] Si vous voulez réaliser une simulation de la Nature, autant le faire avec la Mécanique quantique, et pardi, c'est un problème merveilleux, car ça ne semble pas si facile. » Feynman croyait que, parce qu'il mettrait en œuvre les principes mêmes du fonctionnement de la matière à l'échelle subatomique, un tel simulateur pourrait modéliser le fonctionnement même de l’univers. Ce diable d'homme, visionnaire à ses heures, aura-t-il eu raison, une fois de plus? Seul l'avenir le dira.

(À suivre…)

- 1En fait, les choses sont un peu plus complexes, car en lui-même, le courant n'est pas l'information, c'est seulement le moyen utilisé pour donner aux supports physiques de la mémoire un des deux états binaires désirés, et il existe plusieurs types de mémoire électroniques. Mais pour les besoins de ce texte, il n'est pas nécessaire de les détailler.

- 2C est la vitesse de la lumière dans le vide ; elle diminue dans le câble et les divers matériaux utilisés dans un ordinateur pour se situer dans une fourchette variant de 50 à 99 % de cette limite optimale.

- 3Cela dit, il ne faut jamais oublier qu'un ordinateur est un appareil complexe et qu'il s'apparente en ce sens à une chaîne systémique : sa vitesse globale sera toujours fonction de sa composante la plus lente. Ajoutons à cela que les systèmes d'exploitation sont de plus en plus lourds et que les ordinateurs proposent de plus en plus d'options...

- 4En fait, il existe plusieurs versions de la loi de Moore, dont certaines ne sont d'ailleurs pas de lui. Pour les besoins de ce texte, nous ne retenons ici que la version la plus connue.

- 5Les progrès de la miniaturisation ont été spectaculaires, surtout depuis la création du microprocesseur par l'ingénieur d'Intel Marcian Hoff, en 1969. Les fabricants arrivent actuellement à graver des transistors de quelques nanomètres, soit quelques milliardièmes de mètre.

- 6 En fait, certaines parties des ordinateurs actuels exploitent déjà les principes de la mécanique quantique, mais de manière marginale ; l'ordinateur quantique leur accorde au contraire une place centrale.

- 7Pour être précis, il faudrait dire en fait que chaque état quantique peut prendre plusieurs valeurs, qui s'appliquent à diverses quantités observables, comme la position de l'onde-particule, son spin ou sa quantité de mouvement.

- 8Astronomique, le chiffre précis s'obtient aisément avec une simple calculatrice : 9 007 199 254 740 992. Cependant, comme tous les grands nombres, le quadrillion a une valeur différente selon que l'on utilise la notation française ou anglaise, l'échelle longue ou courte. Pour ceux et celles plus familiers avec ces notions, précisons qu'on parle ici d'un quadrillion en échelle courte, l'équivalent d'un billiard en échelle longue.

- 9 Rappelons que la capacité de traitement d'un microprocesseur classique est fonction directe du nombre de transistors : plus il en contient, plus il pourra effectuer d'opérations complexes ou de calculs impliquant des grands nombres.

- 10 Pour le Japon, on parle par exemple de la compagnie Fujitsu (voir à ce propos https://www.nextbigfuture.com/ 2019/08/fujitsu-has-a-1-million-qubit-quantum-annealer-in-the-lab-and-8192-qubits-commercially-available.html) ; pour ce qui est de la Chine, ce sont des entreprises aux reins solides qui investissent massivement dans ce domaine de pointe, comme l'équipementier Huawei, maintenant bien connu en Occident pour des raisons politiques, mais aussi BAT, le célèbre triumvirat comprenant Baidu, le Google chinois (voir le Baidu Quantum Computing Institute), Alibaba, l'Amazon chinois (voir son Alibaba Quantum Computing Laboratory, situé à Shanghai) et Tencent, le fournisseur de réseaux sociaux et de services basé à Shenzen (voir le Tencent Quantum Lab). Quant aux universités nationales, elles ne sont pas en reste, comme le montre la Chinese Academy of Sciences, avec entre autres avec son Key Laboratory of Quantum Information.

- 11De nombreux médias spécialisés ont rendu compte de cet événement spectaculaire ; voir par exemple https://www.datacenterdynamics.com/news/ces-ibm-announces-q-system-one-quantum-computer-9ft-cube/.

- 12Voir à ce propos https://www.datacenterdynamics.com/news/microsoft-hopes-to-build-topological-quantum-computer/.

- 13Voir https://www.generation-nt.com/intel-tangle-lake-puce-qubits-quantique-actualite-1953561.html.

- 14L'annonce a en effet généré une petite controverse dans le monde sélect des entreprises engagées dans cette compétition effrénée. Elle est venue entre autres des ingénieurs d'IBM, ceux-là mêmes qui ont conçu l'appareil rival. Pour prendre connaissance de leurs réserves, on peut consulter le texte publié à cette occasion, à l'adresse URL suivante : https://www.ibm.com/blogs/research/2019/10/on-quantum-supremacy/.

- 15Une version PDF du texte est disponible à l'adresse URL suivante : https://www.nature.com/articles/s41586-019-1666-5.pdf.

- 16 Prononcée en 1981, la conférence ne fut publiée qu'en 1982, dans l'International Journal of Theoretical Physics, vol. 21, nos 6-7, p. 467-488. On en trouvera le texte à l'adresse URL suivante : https://link.springer.com/article/ 10.1007/BF02650179.

- Jean-Claude Simard

Université du Québec à Montréal

Jean-Claude Simard a longtemps enseigné la philosophie au Collège de Rimouski, puis l’histoire des sciences et des techniques à l’Université du Québec à Rimouski, d'où il est présentement professeur retraité. Il croit que la culture scientifique a maintenant conquis ses lettres de noblesse et que, tant pour le grand public que pour le scientifique ou le philosophe, elle est devenue tout simplement incontournable dans le monde actuel.

Vous aimez cet article?

Soutenez l’importance de la recherche en devenant membre de l’Acfas.

Devenir membre

Commentaires

Articles suggérés

Infolettre